近日,科技界迎來了一項新的突破,meta公司正式發布了WebSSL系列模型,這一系列模型基于純圖像數據進行訓練,旨在探索無語言監督的視覺自監督學習(SSL)的潛力。此舉標志著meta在視覺學習領域邁出了重要一步。

在當前的視覺學習領域,以OpenAI的CLIP為代表的對比語言-圖像模型已成為學習視覺表征的熱門選擇。這類模型在視覺問答(VQA)、文檔理解等多模態任務中展現出了卓越的性能。然而,語言依賴成為了一個限制因素,由于數據集獲取的復雜性和數據規模的限制,語言依賴面臨著諸多挑戰。meta公司正是針對這一痛點,推出了WebSSL系列模型。

WebSSL系列模型涵蓋了DINO和Vision Transformer(ViT)兩種架構,參數規模從3億到70億不等。這些模型在Hugging Face平臺上發布,為研究和應用提供了極大的便利。值得注意的是,這些模型僅使用了metaCLIP數據集(MC-2B)中的20億張圖像子集進行訓練,完全排除了語言監督的影響。

WebSSL模型采用了兩種視覺自監督學習范式:聯合嵌入學習(DINOv2)和掩碼建模(MAE)。在訓練過程中,統一使用了224×224分辨率的圖像,并凍結了視覺編碼器,以確保結果差異僅源于預訓練策略。這一設計使得WebSSL模型能夠在不受數據和模型規模限制的情況下,深入評估純視覺自監督學習的表現潛力。

模型在五個容量層級(ViT-1B至ViT-7B)上進行了訓練,并基于Cambrian-1基準測試進行了評估。該基準測試覆蓋了通用視覺理解、知識推理、OCR和圖表解讀等16個VQA任務。實驗結果顯示,隨著參數規模的增加,WebSSL模型在VQA任務上的表現接近對數線性提升,而CLIP在超過30億參數后性能趨于飽和。

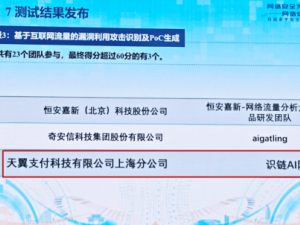

在OCR和圖表任務中,WebSSL模型的表現尤為突出。經過數據篩選后,僅用1.3%的富文本圖像進行訓練,WebSSL模型就在OCRBench和ChartQA任務中實現了高達13.6%的性能提升。這一成果充分展示了WebSSL模型在特定任務中的卓越性能。

WebSSL模型在高分辨率(518px)微調方面也表現出色,進一步縮小了與SigLIP等高分辨率模型的差距。在文檔任務中,WebSSL模型更是展現出了卓越的性能。這一成果不僅驗證了WebSSL模型在視覺學習領域的潛力,也為未來的研究提供了重要的參考。

WebSSL模型在無語言監督下仍展現出與預訓練語言模型(如LLaMA-3)的良好對齊性。這表明大規模視覺模型能夠隱式學習與文本語義相關的特征,為視覺與語言的交叉研究提供了新的思路。

同時,WebSSL模型在傳統基準測試(如ImageNet-1k分類、ADE20K分割)上也保持了強勁的表現。部分場景下,WebSSL模型甚至優于metaCLIP和DINOv2等現有模型。這一成果進一步證明了WebSSL模型在視覺學習領域的領先地位。