谷歌DeepMind首席執行官德米斯·哈薩比斯近日公開表示,將現有AI模型的規模擴展至極限是實現通用人工智能(AGI)的核心路徑。這位憑借Gemini 3模型引發行業關注的科學家認為,單純依靠擴大模型參數、增加訓練數據和計算資源,可能成為構建AGI的關鍵組成部分,甚至直接構成完整系統。但他同時指出,完全依賴規模定律或許存在局限性,最終可能需要一到兩次技術突破才能徹底突破瓶頸。

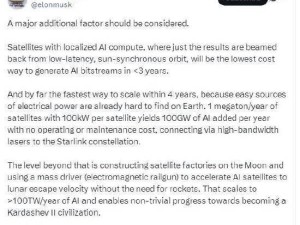

規模定律作為機器學習領域的核心原則,描述了模型性能與規模、數據量及算力之間的量化關系。其通俗理解可概括為:參數規模越大、訓練數據越豐富、計算時間越長,模型智能水平越高。這一經驗性規律已成為當前大模型研發的核心依據,全球頂尖科技公司均圍繞其展開技術競賽。但哈薩比斯承認,該路徑面臨現實挑戰——公開可用數據總量存在天然上限,持續增加算力不僅推高訓練成本,還會加劇能源消耗與碳排放問題。

行業內部對此存在顯著分歧。前meta首席AI科學家楊立昆(Yann LeCun)公開質疑規模定律的普適性。他在新加坡國立大學演講時強調,多數復雜問題無法通過單純堆砌數據和算力解決,例如需要理解物理世界的場景。這位近期離職創業的學者透露,其新項目將聚焦構建"世界模型",通過空間數據而非語言數據訓練AI,試圖開辟區別于大語言模型的技術路線。

當前AI領域對AGI的探索呈現兩條并行路徑:一條延續規模定律,通過持續擴大模型邊界逼近人類智能;另一條則試圖突破現有框架,尋找更高效的認知架構。哈薩比斯代表的第一陣營認為,現有技術路線尚未觸及理論極限,而楊立昆等學者則警告過度依賴規模可能導致資源錯配。這場爭論折射出AI發展進入深水區后的戰略選擇困境——在算力競賽與范式革新之間,行業尚未形成共識性方向。