DeepSeek公司近期宣布,其R1模型已順利完成一次重要的版本迭代,新版本被命名為DeepSeek-R1-0528。這一消息于5月29日晚間正式對(duì)外發(fā)布。

據(jù)悉,DeepSeek-R1-0528依舊基于2024年12月推出的DeepSeek V3 Base模型構(gòu)建,但在后訓(xùn)練階段加大了算力的投入,從而顯著增強(qiáng)了模型的思維深度和推理能力。這一改進(jìn)使得R1模型在多個(gè)關(guān)鍵領(lǐng)域的表現(xiàn)上邁上了新的臺(tái)階。

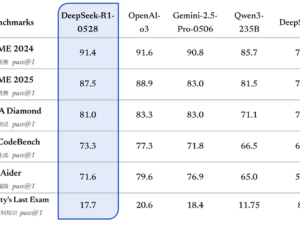

在新版本的測(cè)評(píng)中,DeepSeek-R1-0528在數(shù)學(xué)、編程以及通用邏輯等領(lǐng)域均取得了卓越的成績(jī),不僅在國(guó)內(nèi)模型中獨(dú)占鰲頭,而且在整體表現(xiàn)上已經(jīng)逼近了國(guó)際頂尖模型,如o3和Gemini-2.5-Pro。這一成就標(biāo)志著DeepSeek在人工智能領(lǐng)域的技術(shù)實(shí)力又向前邁進(jìn)了一大步。

特別是在復(fù)雜推理任務(wù)的處理上,新版R1模型相較于舊版有了質(zhì)的飛躍。以AIME 2025測(cè)試為例,新版模型的準(zhǔn)確率從舊版的70%大幅提升至87.5%。這一顯著進(jìn)步得益于模型在推理過(guò)程中思維深度的增強(qiáng),使得它能夠更加深入地分析和解決問(wèn)題。

新版R1模型在解題過(guò)程中使用的tokens數(shù)量也大幅增加。在AIME 2025測(cè)試集上,舊版模型平均每題使用12K tokens,而新版模型則達(dá)到了23K tokens。這一變化表明,新版模型在解題時(shí)進(jìn)行了更為詳盡和深入的思考,從而得出了更為準(zhǔn)確的答案。

DeepSeek還利用DeepSeek-R1-0528的思維鏈對(duì)Qwen3-8B Base進(jìn)行了蒸餾訓(xùn)練,成功推出了DeepSeek-R1-0528-Qwen3-8B模型。這一8B模型在數(shù)學(xué)測(cè)試AIME 2024中的表現(xiàn)同樣令人矚目,僅次于DeepSeek-R1-0528,超越了Qwen3-8B(+10.0%),與Qwen3-235B旗鼓相當(dāng)。這一成果進(jìn)一步證明了DeepSeek在模型優(yōu)化和訓(xùn)練方面的卓越能力。

DeepSeek表示,DeepSeek-R1-0528的思維鏈對(duì)于學(xué)術(shù)界和工業(yè)界都具有重要意義。它將有助于推動(dòng)推理模型的研究和發(fā)展,并為小模型的開(kāi)發(fā)提供新的思路和方法。

除了推理能力的提升外,新版DeepSeek R1還在其他方面進(jìn)行了優(yōu)化。針對(duì)“幻覺(jué)”問(wèn)題,新版模型進(jìn)行了針對(duì)性改進(jìn)。與舊版相比,更新后的模型在改寫(xiě)潤(rùn)色、總結(jié)摘要、閱讀理解等場(chǎng)景中,幻覺(jué)率降低了約45%~50%,從而能夠?yàn)橛脩?hù)提供更加準(zhǔn)確和可靠的結(jié)果。

在創(chuàng)意寫(xiě)作方面,新版R1模型也取得了顯著進(jìn)步。它在議論文、小說(shuō)、散文等文體上進(jìn)行了優(yōu)化,能夠輸出篇幅更長(zhǎng)、結(jié)構(gòu)更完整、內(nèi)容更豐富的長(zhǎng)篇作品。同時(shí),其寫(xiě)作風(fēng)格也更加貼近人類(lèi)的偏好,使得生成的文本更加自然和流暢。