蘋果內(nèi)部消息透露,其人工智能平臺(tái)“Apple Intelligence”正加速邁向2.0版本,計(jì)劃在接下來兩年內(nèi)帶來一系列重大更新。這次迭代將主要圍繞Siri底層架構(gòu)的重塑、第三方AI模型的深度整合以及原生應(yīng)用的智能化拓展展開。

“Apple Intelligence”平臺(tái)的發(fā)展步入新階段,Siri作為其核心組成部分,將迎來一場(chǎng)“大語言模型”革命。據(jù)悉,代號(hào)“LLM Siri”的新一代語音助手將摒棄傳統(tǒng)的規(guī)則引擎,轉(zhuǎn)而采用蘋果自主研發(fā)的千億參數(shù)級(jí)大語言模型。這一轉(zhuǎn)變將使Siri能夠?qū)崿F(xiàn)更加流暢的多輪對(duì)話,并通過“App Intents”框架跨應(yīng)用執(zhí)行復(fù)雜指令,例如自動(dòng)整理并分享特定照片。然而,由于需要協(xié)調(diào)多部門接口,這一功能預(yù)計(jì)將在2026年春季隨iOS 19.4版本推出。

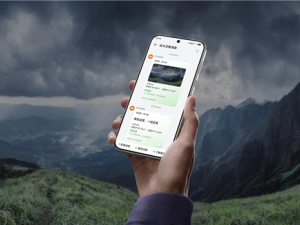

蘋果在構(gòu)建開放生態(tài)方面邁出重要一步,正考慮將ChatGPT、谷歌Gemini、Perplexity等主流AI模型納入其兼容性測(cè)試名單。未來,用戶或可在系統(tǒng)設(shè)置中自由切換不同的AI引擎,這一舉措被視為蘋果構(gòu)建“AI服務(wù)層”的關(guān)鍵一環(huán)。此舉不僅將提升用戶體驗(yàn),還將進(jìn)一步推動(dòng)AI技術(shù)的普及和應(yīng)用。

蘋果原生應(yīng)用也在逐步融入AI技術(shù)。根據(jù)代碼分析,音樂App將測(cè)試AI生成播放列表封面的功能,郵件App將提供智能附件整理服務(wù),而健康A(chǔ)pp則將能夠根據(jù)用戶習(xí)慣生成個(gè)性化的運(yùn)動(dòng)計(jì)劃。這些基礎(chǔ)特性有望在今年秋季隨iOS 18版本首發(fā),為用戶帶來更加智能化的使用體驗(yàn)。

為了確保用戶體驗(yàn)的平穩(wěn)過渡和開發(fā)者有足夠的時(shí)間進(jìn)行適配,蘋果將采取分階段發(fā)布策略。2025年秋季發(fā)布會(huì)將重點(diǎn)展示AI基礎(chǔ)功能的落地情況,而2026年的WWDC開發(fā)者大會(huì)則將主推“LLM Siri”及開放生態(tài)戰(zhàn)略。這種軟硬件協(xié)同的推進(jìn)模式,既避免了大規(guī)模一次性升級(jí)可能帶來的用戶體驗(yàn)斷層,也為開發(fā)者提供了更多的準(zhǔn)備時(shí)間。