在AI開源社區的熱烈期待中,DeepSeek開源周迎來了又一高潮:DeepEP,一個專為MoE模型訓練和推理設計的EP通信庫,正式向全球開發者開放。這一創新之舉,標志著AI算力優化領域的一次重大突破。

在AI模型的訓練過程中,GPU集群的算力分配和數據傳輸一直是制約效率的瓶頸。傳統分布式訓練中,不同GPU之間的算力常常無法同步,導致算力資源的浪費。而DeepEP的出現,則像為AI算力世界制定了一套全新的交通規則,讓數據流動更加高效有序。

DeepEP的亮點在于其高效的多對多通信機制,以及對NVLink和RDMA技術的原生支持。它還配備了預填充的高吞吐量內核和低延遲內核,專為訓練和推理設計。更重要的是,DeepEP引入了FP8智能壓縮技術,進一步縮減了數據傳輸量,配合預填充機制,實現了計算與通信的高效重疊。

在實測中,DeepEP的表現令人矚目。在千卡規模的GPU集群中,它顯著降低了通信等待時間,讓AI模型的訓練和推理過程更加流暢。這一突破,無疑為AI算力優化領域帶來了新的曙光。

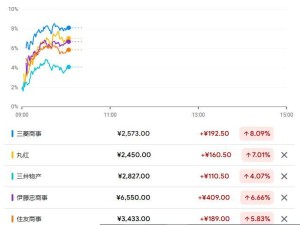

DeepEP的開源,也引發了開發者的熱烈反響。在Github上,DeepEP的Star數量迅速攀升,截至發稿時已超過2.7k。網友們紛紛表示,DeepEP的引入可能會徹底改變AI和區塊鏈應用程序的互操作性,降低開發成本,提高任務性能。

更有開發者高度評價DeepSeek團隊的工作,認為他們正在為AI基礎設施領域帶來前所未有的變革。DeepEP的創新group-limited gating機制,讓專家網絡間的協作效率實現了質的飛躍,為AI模型的訓練和推理提供了新的可能。

DeepEP的開源,不僅是一次技術的分享,更是對AI未來的一次深遠布局。DeepSeek團隊將如此核心的技術完全開放給全球開發者,無疑將激發更多創新火花,推動AI技術的快速發展。

可以預見,隨著DeepEP的廣泛應用,AI模型的訓練和推理效率將得到顯著提升,為AI技術的普及和應用開辟更加廣闊的道路。DeepSeek團隊的這一開源之舉,無疑為AI世界注入了一股強勁的動力。