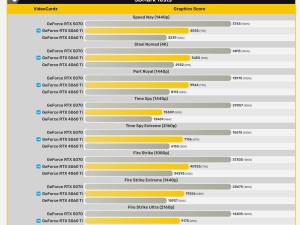

近期,LMArena更新了大型語言模型的排名,引發(fā)了一場關(guān)于meta最新發(fā)布的開源大模型Llama-4-Maverick真實(shí)性能的廣泛討論。此前,Llama-4-Maverick在LMArena的Chatbot Arena LLM排行榜上高居第二,僅次于Gemini 2.5 Pro。然而,這一排名近日卻發(fā)生了戲劇性的變化,Llama-4-Maverick直線下降至第32名。

這一變化源于開發(fā)者對meta提供給LMArena的Llama 4版本產(chǎn)生質(zhì)疑。有開發(fā)者指出,meta提交給LMArena的版本與向社區(qū)公開的開源版本存在顯著差異,懷疑meta為了刷榜而提供了“特供版”。這一質(zhì)疑迅速在開發(fā)者社區(qū)中發(fā)酵,引發(fā)了廣泛的關(guān)注和討論。

為了回應(yīng)這些質(zhì)疑,Chatbot Arena官方于4月8日發(fā)文確認(rèn)了開發(fā)者的猜測。官方表示,meta首次提交給他們的Llama-4-Maverick版本是一個實(shí)驗(yàn)性聊天優(yōu)化版本,即Llama-4-Maverick-03-26-Experimental。該版本在LMArena上取得了不錯的排名,但隨后曝光的開源版本卻表現(xiàn)平平。

隨著更多關(guān)于開源版Llama-4-Maverick性能的信息曝光,該模型的口碑急劇下滑。開發(fā)者發(fā)現(xiàn),開源版Llama-4-Maverick在LMArena的排名遠(yuǎn)低于Gemini 2.5 Pro、GPT4o等競爭對手,甚至連基于上一代Llama 3.3改造的模型都不如。這一發(fā)現(xiàn)進(jìn)一步加劇了開發(fā)者對meta刷榜行為的質(zhì)疑。

針對這一爭議,meta方面給出了回應(yīng)。一位meta發(fā)言人表示,meta確實(shí)嘗試了“各種類型的定制變體”,其中Llama-4-Maverick-03-26-Experimental是針對聊天優(yōu)化的版本。該發(fā)言人稱,這一版本在LMArena上表現(xiàn)不錯,但meta隨后發(fā)布了開源版本,并期待開發(fā)者根據(jù)自己的使用案例進(jìn)行定制。

然而,盡管meta給出了回應(yīng),但開發(fā)者社區(qū)的質(zhì)疑并未因此平息。許多開發(fā)者認(rèn)為,針對基準(zhǔn)測試調(diào)整模型不僅具有誤導(dǎo)性,還使得他們難以準(zhǔn)確預(yù)測該模型在不同場景下的表現(xiàn)。這一事件再次引發(fā)了關(guān)于AI模型性能評估和排名的廣泛討論。

在這場爭議中,LMArena的排名也受到了質(zhì)疑。有開發(fā)者指出,盡管LMArena是一個重要的基準(zhǔn)測試平臺,但其排名結(jié)果并非衡量AI模型性能的最可靠指標(biāo)。這一觀點(diǎn)得到了許多開發(fā)者的認(rèn)同。

隨著討論的深入,越來越多的開發(fā)者開始關(guān)注AI模型的實(shí)用性和場景適應(yīng)性。他們認(rèn)為,真正的AI模型應(yīng)該能夠在各種實(shí)際場景中表現(xiàn)出色,而不僅僅是在某個特定的基準(zhǔn)測試上取得高分。這一觀點(diǎn)逐漸成為了開發(fā)者社區(qū)的主流聲音。